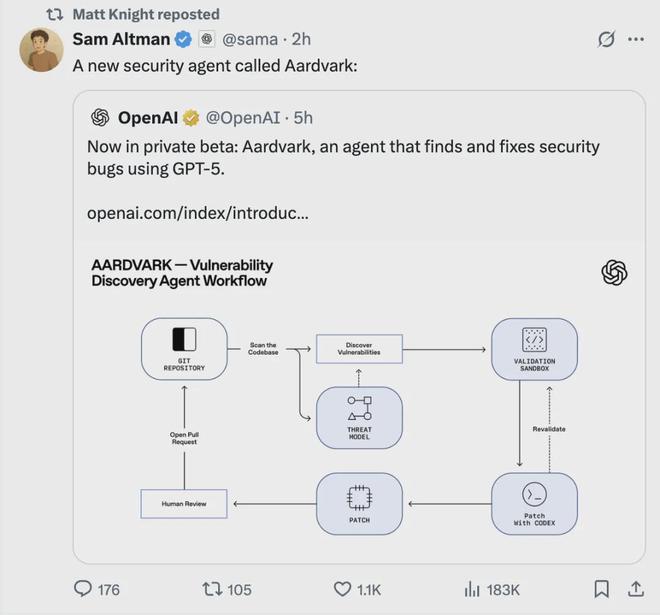

AI Coding火了大半年,AI Debugging也來了!

剛剛,OpenAI發(fā)布由GPT-5驅(qū)動的“白帽”Agent——Aardvark(土豚)

這只“AI安全研究員”能幫助開發(fā)者和安全團(tuán)隊(duì),在大規(guī)模代碼庫中自動發(fā)現(xiàn)并修復(fù)安全漏洞

據(jù)OpenAI報(bào)告,Aardvark已識別出了92%的已知與人工注入漏洞,而且能定位僅在復(fù)雜條件下出現(xiàn)的問題。

OpenAI副總裁Matt Knight表示:

- 我們的開發(fā)者發(fā)現(xiàn),土豚在清晰地解釋問題并引導(dǎo)他們找到修復(fù)方案方面確實(shí)非常有價(jià)值。這個信號告訴我們,我們正走在一條有意義的道路上。

而且,不僅OpenAI。

整個10月Anthropic谷歌微軟基本上是前腳跟后腳發(fā)布了類似的白帽Agent。

這是怎么一回事。

Agentic AI +自動修補(bǔ)漏洞

OpenAI對這款白帽Aardvark的官方描述是——代理型安全研究員(agentic security researcher)

Aardvark的核心任務(wù)是持續(xù)分析源代碼倉庫,以識別安全漏洞、評估可利用性、確定風(fēng)險(xiǎn)等級,并提出有針對性的修復(fù)方案。

它通過監(jiān)控代碼提交(commits)與變更來工作,自動識別潛在漏洞、推斷攻擊路徑并生成修復(fù)建議。

Aardvark并不依賴傳統(tǒng)的程序分析技術(shù)(如模糊測試fuzzing或軟件成分分析SCA),而是運(yùn)用大語言模型驅(qū)動的推理與工具使用能力來理解代碼行為,像人類安全研究員那樣閱讀、分析代碼、編寫測試并運(yùn)行驗(yàn)證。

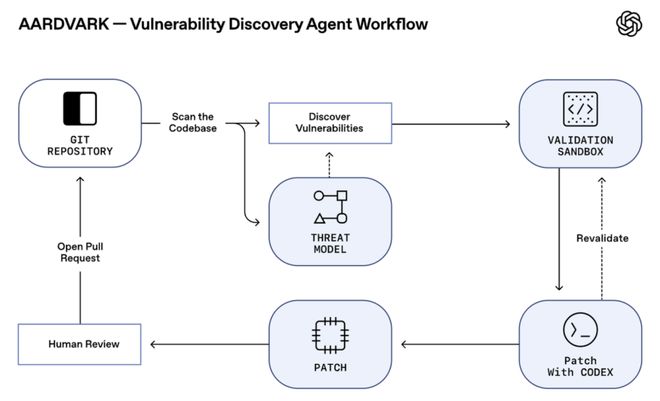

具體來說,它的工作流程從Git倉庫出發(fā),依次經(jīng)歷:威脅建模→漏洞發(fā)現(xiàn)→沙盒驗(yàn)證→Codex 修復(fù)→人工復(fù)審→ 提交Pull Request。

- 分析:對整個倉庫進(jìn)行全面分析,生成反映項(xiàng)目安全目標(biāo)與設(shè)計(jì)的威脅模型(threat model)。

- 提交掃描:新代碼提交時,結(jié)合倉庫和威脅模型掃描差異;首次連接倉庫時回溯歷史提交。同時解釋發(fā)現(xiàn)的漏洞,在代碼中標(biāo)注,便于人工復(fù)審。

- 驗(yàn)證:一旦識別出潛在漏洞,將在隔離環(huán)境中觸發(fā)潛在漏洞,確認(rèn)可利用性,同時說明驗(yàn)證步驟,確保結(jié)果準(zhǔn)確且誤報(bào)率低。

- 修復(fù):Aardvark與OpenAI Codex深度集成,為漏洞生成修復(fù)補(bǔ)丁,附于報(bào)告中,便于一鍵審閱與應(yīng)用。

目前,Aardvark可無縫集成GitHub、Codex及現(xiàn)有開發(fā)流程,在不影響開發(fā)效率的前提下提供可執(zhí)行的安全洞察。

內(nèi)部測試顯示,它不僅能識別安全漏洞,還能發(fā)現(xiàn)邏輯缺陷、不完整修復(fù)及隱私風(fēng)險(xiǎn)

而且,Aardvark 已在內(nèi)部和合作伙伴項(xiàng)目中測試運(yùn)行,表現(xiàn)出色,驗(yàn)證了其實(shí)際可用性。

正如開頭提到的,它不僅能夠進(jìn)行深度分析、定位僅在復(fù)雜條件下出現(xiàn)的問題,在對“黃金測試倉庫(golden repositories)”的基準(zhǔn)測試中,也實(shí)現(xiàn)了92%的識別率。

此外,Aardvark也已應(yīng)用于多個開源項(xiàng)目,發(fā)現(xiàn)并負(fù)責(zé)披露了眾多漏洞,其中10個已獲得CVE編號。