Transformer的時代,正在被改寫。

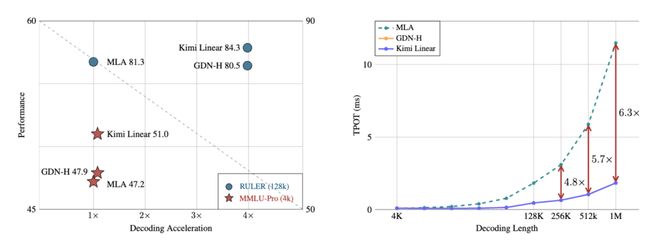

月之暗面最新發布的開源Kimi Linear架構,用一種全新的注意力機制,在相同訓練條件下首次超越了全注意力模型

在長上下文任務中,它不僅減少了75%的KV緩存需求,還實現了高達6倍的推理加速。

有網友表示期待:這個架構下的Kimi K2.5何時來??

不過,咱還是先來看一下Kimi Linear是如何挑戰傳統Transformer的。

讓注意力真正線性化

Transformer確實聰明,但聰明得有點太燒錢。

它的注意力機制是全連接的,每個token都要和其他所有token打交道。

計算量也隨著輸入長度呈平方增長(O(N²)),而且每生成一個新詞,還要查一遍之前的所有緩存。

這就導致推理階段的KV Cache占顯存極大,尤其是在128K以上的上下文中,顯卡直接崩潰警告。

模型越強,顯卡越崩,錢包越痛。

所以,過去幾年無數團隊都在研究線性注意力,希望把計算從 O(N²) 降到 O(N),讓模型能又快又省。

但問題是,以前的線性注意力都記不住東西,快是快了,but智商打折。

現在,Kimi Linear以既要又要還要的姿態登場了。

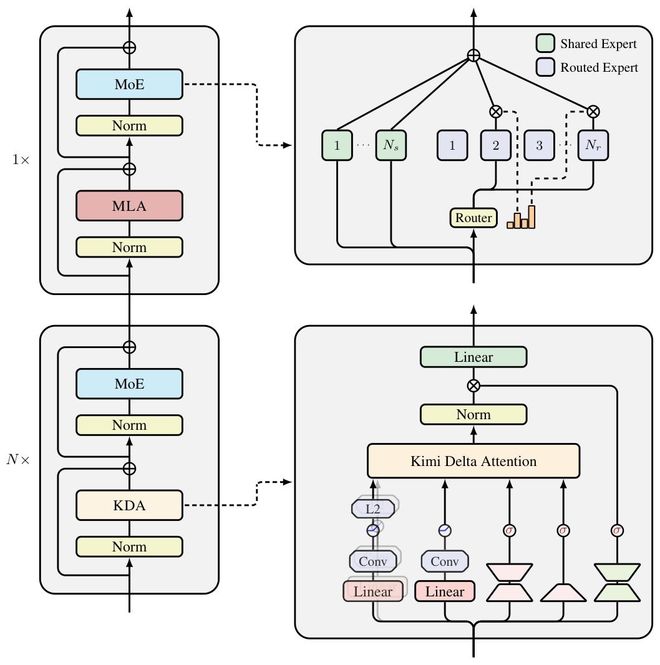

Kimi Linear的核心創新是Kimi Delta Attention(KDA)

它在原有線性注意力的基礎上,引入了細粒度遺忘門控,不再像傳統線性注意力那樣一刀切地遺忘,而是讓模型可以在每個通道維度上獨立地控制記憶保留,把重要信息留下,把冗余信息扔掉。

更關鍵的是,KDA的狀態更新機制是基于一種改進的Delta Rule(增量學習規則)。

它在數學上保證了穩定性,即使是在百萬級token序列中,梯度也不會爆炸或消失。

這也讓Kimi Linear能在超長上下文中跑得穩。

整個模型采用3:1的混合層設計,每3層線性注意力(KDA)后加1層全注意力。這樣既保留全局語義的建模能力,又能在多數層用線性計算節省資源。

團隊還干脆把傳統的RoPE(旋轉位置編碼)砍掉,讓KDA自己通過時間衰減核函數學習序列位置信息。

結果,沒有RoPE,模型反而更穩、更泛化。